近日,软件工程学院(滴水湖国际软件学院)杜德慧教授带领的课题组在人工智能可解释性研究领域取得重大进展,三项研究成果分别被人工智能领域的顶会The 39th Annual AAAI Conference on Artificial Intelligence(AAAI 2025)及workshop(AAAI25-AICT)录用。这三项研究分别从不同维度深入解决人工智能系统的可解释性问题,对于提高AI的可信性具有重要研究意义。

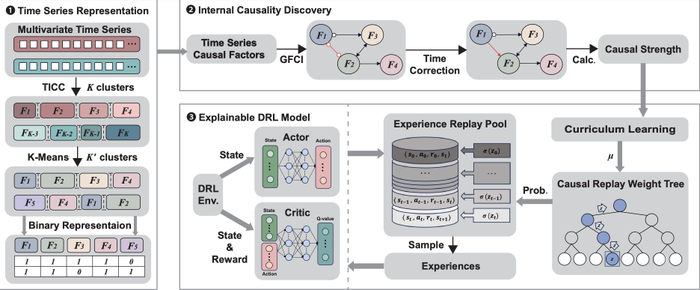

在深度强化学习领域,自动驾驶等安全关键应用受困于深度强化学习(DRL)的黑盒特性与可解释性缺失,难以获得用户的充分信任。同时,传统经验回放方法虽提升了样本效率,却未能有效捕捉训练数据中的因果关系,导致训练过程复杂且解释性不足。课题组创新性地引入了时间序列表示与因果推理的融合机制。通过独特的多元时间序列表示方法,ERCI能够精准提取可解释的时间序列因果因素(TSCF),并将其内部因果关系作为DRL训练中经验回放的核心准则。实验结果表明,ERCI不仅能生成符合人类认知的解释,还显著提升了样本效率,展现出卓越的有效性与普适性。

△ ERCI方法架构

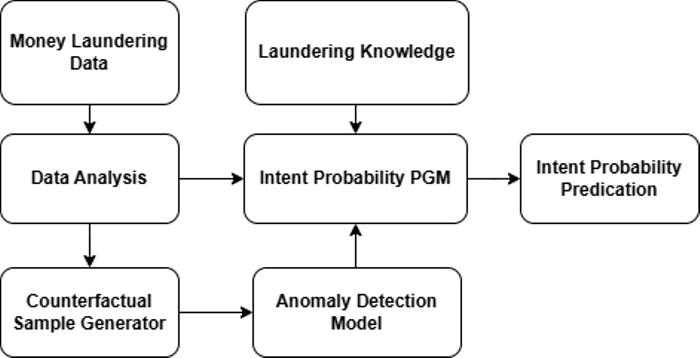

反洗钱行为检测领域同样面临可解释性挑战,黑盒反洗钱算法难以揭示其决策背后的逻辑,无法有效辅助决策者识别洗钱意图。针对该问题,课题组提出基于反事实构建概率图模型的解决方案,通过向数据集注入反事实样本,构建黑盒模型的贝叶斯网络抽象,结合反向推理技术,成功揭示异常交易背后的洗钱意图。在多模型与数据集的实验验证中,该方法展现出强大的模型无关解释能力,为反洗钱决策提供了极具价值的洞察与依据。

△ 反洗钱决策工作流

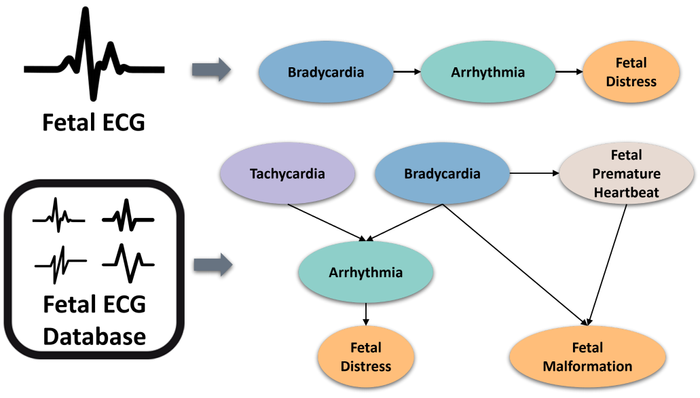

此外,在时间序列分析中,变量内部因果关系的隐匿性严重阻碍了数据分析与分类的准确性与可解释性。课题组提出一种全新的“挖掘因果自然结构”(MCNS)框架。通过时序数据分段与因果发现算法的有机结合,MCNS能够有效挖掘时间序列内部的因果自然结构,利用内部因果关系方案、注意力机制优化及数据集修剪等技术,成功应对子序列因果关系发现与时序数据分类优化的挑战。实验显示,MCNS框架在UCR数据集上准确识别出时序数据的真实因果结构,显著提升了数据分类的准确性与可解释性。

△ 从MCNS获取心电图的因果结构示例

这三项研究成果共同聚焦人工智能可解释性核心问题,从深度强化学习、反洗钱检测及时间序列分析等关键应用领域切入,各自提出针对性解决方案,不仅在理论上取得创新突破,更在实际应用中展现出巨大潜力。课题组的最新成果为提升人工智能系统的可解释性提供了新的理论与方法,有望推动相关领域的技术创新与应用拓展。

相关成果论文列表:

- Jingwen Wang, Dehui Du, Lili Tian, Yikang Chen, Yida Li, YiYang Li ,“ERCI: An Explainable Experience Replay Approach with Causal Inference for Deep Reinforcement Learning”,AAAI 2025

- Zihan Jiang, Dehui Du, Yuanhao Liu ,“Counterfactual Based Probabilistic Graphs for Explainable Money Laundering Detection”,AAAI-AICT 2025

- Xingzhe Sun, Dehui Du,“MCNS: Mining Causal Natural Structures Inside Time Series via A Novel Internal Causality Scheme” ,AAAI-AICT 2025